本文实际发表于2025.05.30,该日期之前的文章皆为建站后补发送。

任务类型

图像级对话任务

GeoChat 处理图像和用户文本查询,利用图像的全局上下文完成对话任务。

区域级对话任务

在图像输入中提供空间框位置 ( b ),引导模型关注图像中的特定区域,完成区域级对话。

具体化对话任务

通过使用特殊标记,引导 GeoChat 完成特定任务。

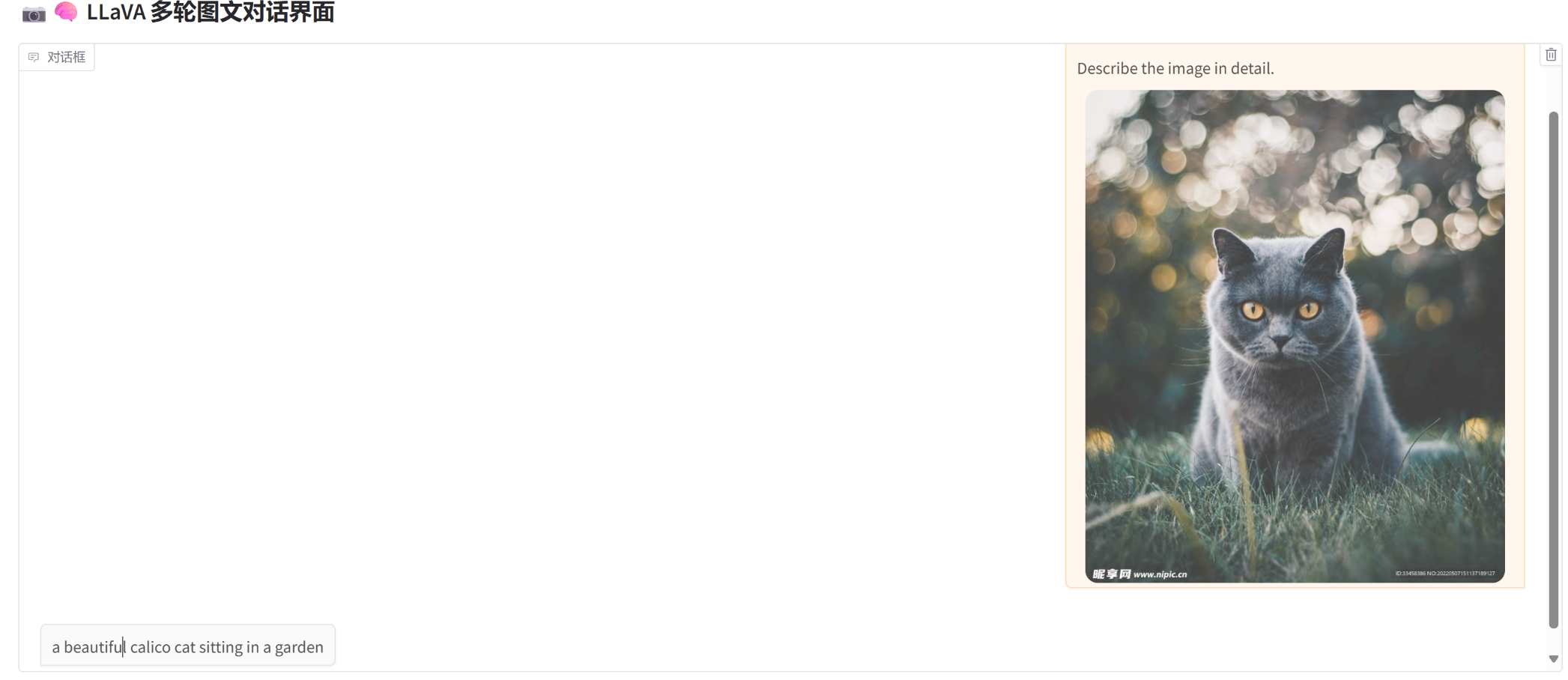

模型架构

GeoChat 整体遵循 LLaVA-v1.5 的架构,由视觉编码器、跨模态适配层和大语言模型组成。

任务标记

使用 {grounding, identify, refer} 三种任务标记,分别用于语义对话、区域描述和指代表达理解。适用于视觉问答(VQA)和场景分类任务。

空间位置标记

空间位置以文本形式表示:

b = { bₓₗₑfₜ, bᵧₜₒₚ, bₓᵣᵢgₕₜ, bᵧbₒₜₜₒₘ | θ }

可直接作为文本输入 LLM,引导区域级对话。

视觉主干

对 CLIP 模型中的位置编码进行插值,适配 504×504 输入图像大小,使模型接收更大分辨率图像。

MLP 跨模态适配器

使用具有一个隐藏层的 MLP,将冻结的 CLIP-ViT 模型输出的 tokens 投影到语言模型空间,实现视觉与语言信息融合。

大语言模型

基于开源 LLM —— Vicuna v1.5(7B)。通过 LoRA 微调策略,有效降低训练资源需求。

LoRA 简介

在原始模型旁引入一个降维再升维的旁路结构,仅训练降维矩阵 A 与升维矩阵 B,保持预训练参数冻结。A 采用随机高斯初始化,B 初始化为零矩阵。推理时将 BA 与主模型输出相加,不改变输入输出维度。

训练细节

模型初始化采用:

- CLIP-ViT (L-14) 编码器(冻结)

- MLP 跨模态适配器(冻结)

- Vicuna-v1.5(LoRA 微调)

数据集构建

数据组成

整合三类任务数据集:

- 目标检测与识别:DOTA、DIOR、FAIR1M,共同构建 SAMRS 数据集

- 场景分类:NWPURESISC-45

- 视觉问答(VQA):LRBEN、洪水检测 VQA 数据集

添加缺失类别

通过其他模型推理图像中未标注类别(如建筑、道路、树木),提升标注完备性。

属性提取

依据目标在图中的方位、面积、像素值等特征,提取出相对位置、颜色、大小等属性信息。

表达式生成

自动生成对象的文本描述及对象之间的关系语句,辅助模型理解和回答。

复现结果(环境:RTX 4090 24G)

场景分类任务

- AID 验证集(3000 张):准确率 71.97%(论文中为 72.03%)

- UCmerced 验证集(2100 张):准确率 84.48%(论文中为 84.43%)

VQA 问答任务(LRBEN 验证集 10004 张)

总准确率:90.63%(不含计数任务)

- 城乡分类:91.00%

- 存在性检测:91.03%

- 比较任务:90.33%

- 计数任务准确率:25.31%

论文中准确率:90.70%

- 城乡分类:94.00%

- 存在性检测:91.09%

- 比较任务:90.33%

注:由于 HRBEN 数据集体积过大,下载速度慢,未进行评估。

区域描述 / 视觉定位任务

评估数据集链接已失效,未能进行评估。

GeoChat阅读复现

沙发😀

😀